tu crois que sa va etre resolu en 6 max no limit ?

Cela dépend de ce qu’on appelle resolu.

Ici il semble que c’est plus par un système d’quti-apprentissage que de la GTO seule.

La puissance de calcul nécessaire est totalement ridicule pour jouer (deux cpus je crois)

L’étude telle que publiée :

https://science.sciencemag.org/content/early/2019/07/10/science.aay2400

On ne peut pas dire que ça avance, on peut dire que l’ IA a plié les participants, nommés dans l’étude. En revanche, le sample reste sur 10kh. Je comprends pas que ça ne fasse pas plus de bruit…

Mouais. Un peu dubitatif par rapport aux conclusions de la presse généraliste au regard de l’échantillon.

J’ai regardé d’autres sources.

Ah bon, c’est compliqué de donner les résultats chiffrés ?

Evidemment un winrate sur 10K mains ne va rien évoquer au grand public mais bon au moins les gains et perte de chacun, ça donnerait une indication.

C’est vite dit du coup.

Peut-être qu’ils ont chatté sur 10 000 mains en ajoutant des randoms sur les actions et sizings ![]()

Les 12 meilleurs mondiaux : sur quel critère ? Plus de 1 millions de gain ? Mouais …

Remarque : l’IA n’a rien donnée comme idée sur la manière optimale de jouer vu que même les concepteurs ne savent pas (voir plus loin).

Donc en gros, l’ordinateur a joué GTO (ou random, on ne sait pas trop) pour ne pas finir à l’équilibre mais ‹ écraser › les 5 humains issus de la crème de la crème ?

Mouais et si c’était simplement un coup marketing de Facebook ?

C’est ça. Laissons Facebook implémenter ses algorithmes dans les domaines de la sécurité, la bourse, … Sur un malentendu ça peut marcher ![]()

Je ne dis pas que l’ordinateur ne progresse pas pour « résoudre » de plus en en plus de jeux : j’en suis convaincu (un peu moins pour la transposition directe à d’autres domaines).

Néanmoins il faudrait des sources plus spécialisées et détaillées pour vérifier la portée de ce type d’annonce et un minimum d’approche scientifique pour en tirer des conclusions.

Bien, ça a l’air un peu plus détaillé et méthodologique comme source.

Je vais regarder en détail mais on a effectivement les mêmes remarques

Du danger de la vulgarisation quand on y ajoute la traduction …

J’avais un peu tiqué sur la phrase en français mais si ça permet que le field FR décide désormais de jouer ses 99 comme ses TT, ça m’arrange

Top reg le yvan

C’est souvent le cas avec les systèmes d’apprentissage.

Cela ne les empêche pas d’être performantd

Oui bien sûr mais même si le logiciel est performant par auto-apprentissage, ça ne permet pas de savoir quelle est sa stratégie qui serait ‘optimale’ (et encore le terme est galvaudé car à plusieurs joueurs, il ne s’agit pas de l’implémentation d’un équilibre de Nash mais simplement d’auto-apprentissage en jouant contre lui-même).

Les concepteurs concluent que leur programme n’inclut pas de limp hormis de SB dans sa stratégie mais bien des donkbets (et plus souvent que les humains … enfin ceux qui ont joué les quelques mains). La belle affaire. La théorie n’a pas fait un grand pas …

Le problème qui n’est pas mis en avant dans les articles de vulgarisation, c’est bien la question du jugement de la performance sur aussi un sample aussi petit.

OK 4,8bb/100 mains, c’est un bon winrate mais sur un échantillon de 10K mains, ça ne veut rien dire (sans compter que l’on pourrait challenger aussi l’AIVAT et la marge d’erreur).

C’est la conclusion des auteurs (et donc de la presse en général) qui me gène.

C’est trop tôt pour dire que l’ordinateur ‘écrase’ les humains en NLHE 6max.

Ils devraient tenter l’expérience 10K mains avec 5 dégens pour voir

Mais bien entendu la question des logiciels qui progressent et vont continuer à progresser jusqu’à battre inéluctablement les humains est intéressante.

C’est juste plus difficile à juger au poker qu’aux échecs par exemple.

Remarque : les humains ne pouvaient pas trop user de leur avantage d’adaptation ou contrer la stratégie de l’ordinateur …

… car ils ne savaient pas lequel était l’ordinateur et qu’en moyenne, chaque humain n’a joué que 5000 mains. En 6-Max, c’est vraiment peu pour contrer une stratégie d’ordinateur et je suppose qu’ils n’avaient pas le droit au tracker

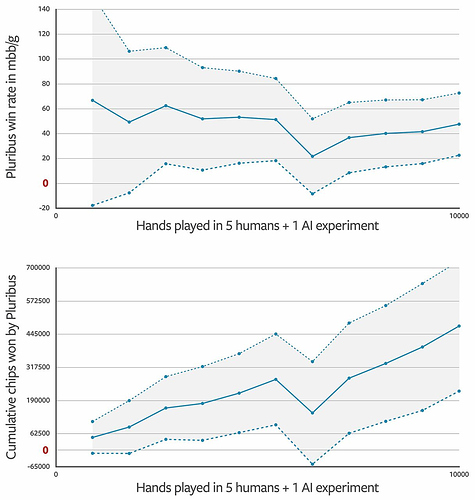

“After applying AIVAT, Pluribus won an average of 48 mbb/game (with a standard error of 25 mbb/game). This is considered a very high win rate in six-player no-limit Texas hold’em poker, especially against a collection of elite professionals, and implies that Pluribus is stronger than the human opponents.”

J’suis pas certains de tout saisir la. Ce qu’ils appellent 1 game c’est 1 main du coup ?

Si oui, 48mbb/hand = 4.8bb/100.

Ici on voit sur le 2nd graph que Pluribus a pris 45 caves ?? en 10kh ? ça fait 45bb/100 de WR net, j’miss quelque chose quelque part ?

Et pourquoi le WR commence à 60, et reste BE ensuite voire drop un peu alors que les chips montent en flèche ?

Oui l’article n’est pas explicite sur l’ensemble des termes et conditions de jeu.

Je pense que ‘game’ veut dire main car ça donne un winrate cohérent (c’est sûr que c’est déjà un excellent winrate sur des top regs mondiaux  mais bon ça reste 10k/mains).

mais bon ça reste 10k/mains).

Il n’est pas dit que 100 chips représentent 1 cave.

En fait, il semble que ça ne soit pas exactement des conditions de CG.

Est-ce que les joueurs avaient un nombre de jeton initiaux ou bien étaient cavés max 100bb avec recave automatique ? On ne sait pas trop.

En tout cas, ils n’étaient pas rémunérés au stack final mais au nombre de mains jouées avec un facteur lié à la performance (mais sans plus de précision).

Ce n’est pas tout à fait le même jeu du coup.

Apparemment le winrate ne démarre pas à zéro sur la main zéro. Ils commencent la mesure après quelques centaines de main probablement.

Les chips cumulés peuvent continuer de monter même si le winrate moyen chute du moment que le winrate ‘instantané’ reste positif.

Par exemple, on passe d’un winrate de 6bb/100 à 4bb/100 à cause d’un winrate de seulement 2bb/100. N’empêche on continue de gagner de l’argent.

En complément c’est l’application d’AIVAT (They mention that they use AIVAT to reduce variance. > Although poker is a game ... | Hacker News) qui explique que les auteurs considèrent les 10K/mains comme si s’en étaient 100K.

J’espère que AIVAT n’est pas un dérivé de la courbe All-in EV de HM2 ![]()

on est passer de 6bb a 4 bb a quelle limites ?

10kh de mieux en mieux puree

Yes mais je trouve ça étrange ces graph je comprends pas vraiment, si tu win rate baisse tes chips montent moins vite qu’avant la c’est presque le contraire.

Enfin il y a encore beaucoup à lire j’ai du passer seulement sur un quart du doc mais l’explication des résultats pourraient facilement être plus claire quand même je trouve ça dommage pour ce qui est sensé une nouvelle grande avancé dans ce milieu.

C’est juste un exemple proche du debut de la courbe pour expliquer que le winrate moyen peut diminuer mais que les gains continuent d’augmenter.

L’exemple est implicitement sans changement de limite bien sûr.

On peut supposer que la confrontation se deroule sur une même ‘limite’ sinon ça serait vraiment n’importe quoi

Ben la cohérence des deux courbes me semble ok. Quels segments te semblent incohérents ?

Oui je trouve dommage que l’ont ne puisse pas savoir exactement de quelle avancée il s’agit.

Les articles de vulgarisation sont trop géneralistes avec parfois des contre-sens et reprennent la conclusion des auteurs sans esprit critique.

L’article des auteurs est bien sûr plus détaillé mais manque parfois de précision (par exemple standard error n’est pas vraiment défini. Ils ne reprennent pas les notions habituelles comme standard deviation ici alors c’est plus dur à comprendre/vérifier).

Ca devrait normalement être à la portée de grindeurs comme nous et certains points restent obscurs.

Je me demande si ce type d’article est vraiment revu et challengé par des paires.

C’est pas plus mal puisqu’il n’y a pas grand monde dans le poker qui semble s’être rendu compte que, par exemple, les trackers ne savent pas la calculer.

On peut chipoter sur le nombre de mains et tout ce qu’on veut mais c’est passer à coté de l’essentiel.

La puissance de calcul du bot est ridicule, les systèmes d’auto-apprentissage ou “l’IA” apprend à jouer contre elle-même sont redoutables.

S’ils veulent rendre leur bot plus efficace, ils doivent avoir pas mal d’idées d’amélioration.

Et plus le bot jouera contre de vrais joueurs, plus il deviendra difficile à battre.

J’utilise « std Dev bb » de HM2 et les valeurs me paraissent correctes.

OK les concepteurs ont réduit la puissance nécessaire pour mettre au point la stratégie de Pluribus par rapport à celle de Libratus mais il faut être prudent sur la capacité actuel des programmes à être invincibles en NLHE hors HU.

Jetons un œil au principe retenu pour l’auto-apprentissage de Libratus et Pluribus (CFR/CFR+) :

Pour Libratus, en plus de l’auto-apprentissage, il y avait adaptation aux adversaires du tournoi.

Remarque : est-ce vraiment l’IA qui continuait son apprentissage sur un échantillon ridicule par rapport aux calculs d’entraînements ? Du coup, est-ce la recherche du jeu parfait type GTO ou exploitant ou un mixte ?

Ca ne semble pas avoir été l’approche pour Pluribus.

Je ne doute pas que les programmes vont s’améliorer et devenir supérieurs aux être humains dans la plupart des variantes classiques.

La question de l’échantillonnage est quand même une vraie question au poker.

Pour les échecs, on a plus de recul, la valeur d’un être humain est plus facile à déterminer, les parties peuvent être revues … : d’ailleurs ici point de mains pour illustrer la force de la stratégie du programme …

Si le logiciel donkbet à haute fréquence, choisi des sizings inhabituels (comme indiqué dans les témoignages des adversaires) … il peut empêcher les humains de s’adapter sur aussi peu de mains.

Difficile de savoir, s’il choisi une stratégie proche de l’équilibre du coup (ça serait intéressant de faire jouer le bot contre 5 clones de lui-même pour voir s’il est 6 fois EV0 sur 10k mains ![]() ).

).

Et ensuite il faut voir s’il est capable de mixer stratégie exploitante et inexploitable comme un humain sait le faire.

En fait si j’interviens ici c’est bien parce que le sujet m’intéresse et que je ne suis pas un anti-IA.

Mais je pense que pour le poker, on est à l’ère de Deeper Blue où l’on a considéré que l’IA avait battu le meilleur joueur du monde alors qu’il est fort probable que ça soit simplement dû à un bug, que les concepteurs faisaient aussi probablement des ajustements d’algorithmes pour s’adapter vs le joueur et que ce n’était pas de l’AI (plutôt de la puissance de calcul).

A suivre pour les logiciels de poker.